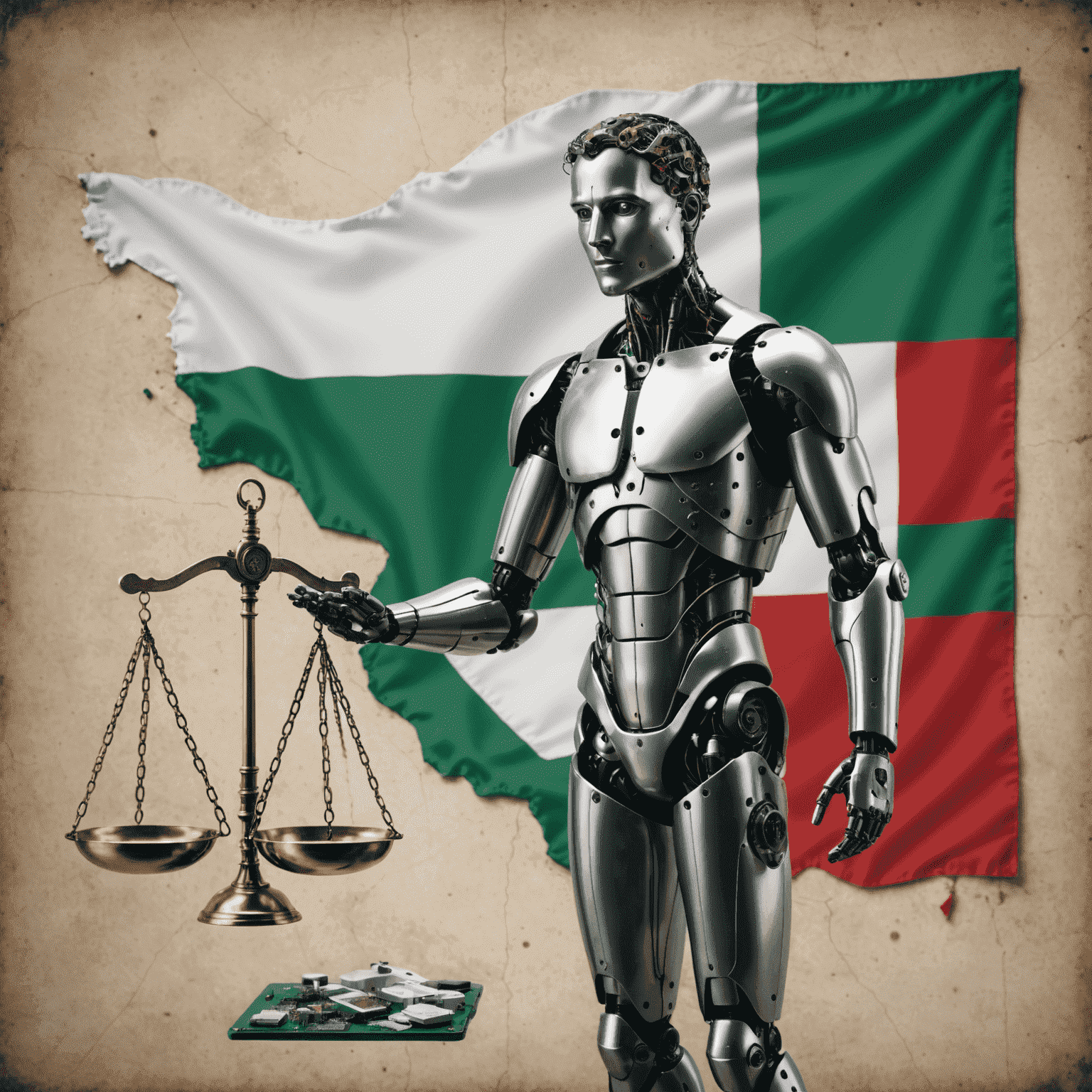

Etica dell'IA nel Contesto Italiano

L'implementazione dell'intelligenza artificiale in Italia solleva importanti questioni etiche che richiedono un'attenta considerazione. Esaminiamo le principali aree di preoccupazione e le misure adottate per garantire un'innovazione responsabile.

Privacy e Protezione dei Dati

In Italia, la privacy è un diritto fondamentale protetto dalla Costituzione. L'adozione dell'IA deve rispettare rigorosamente il Regolamento Generale sulla Protezione dei Dati (GDPR) dell'UE e le leggi nazionali sulla privacy. Le aziende che sviluppano e implementano soluzioni di IA devono garantire:

- Trasparenza nell'uso dei dati personali

- Minimizzazione dei dati raccolti

- Robuste misure di sicurezza per prevenire violazioni dei dati

- Rispetto del diritto all'oblio e alla portabilità dei dati

Mitigazione del Bias

Il bias algoritmico è una preoccupazione significativa nell'implementazione dell'IA. In Italia, dove la diversità culturale e regionale è ricca, è fondamentale garantire che i sistemi di IA non perpetuino o amplifichino pregiudizi esistenti. Gli sviluppatori devono:

- Utilizzare set di dati diversificati e rappresentativi

- Condurre audit regolari per identificare e correggere bias

- Implementare processi di revisione umana per decisioni critiche

- Promuovere la diversità nei team di sviluppo dell'IA

Quadro Normativo

L'Italia, in linea con le direttive dell'Unione Europea, sta sviluppando un quadro normativo robusto per l'IA. Questo include:

- L'adozione dell'AI Act europeo, che classifica le applicazioni di IA in base al rischio

- Linee guida etiche nazionali per lo sviluppo e l'uso dell'IA

- Creazione di organismi di supervisione per monitorare l'implementazione dell'IA

- Incentivi per la ricerca e lo sviluppo di IA etica e responsabile

Trasparenza e Spiegabilità

La fiducia pubblica nell'IA dipende dalla sua trasparenza e spiegabilità. In Italia, si sta promuovendo:

- L'adozione di modelli di IA interpretabili quando possibile

- La creazione di interfacce utente che spieghino le decisioni dell'IA in modo comprensibile

- L'obbligo di divulgare quando si interagisce con un sistema di IA anziché con un umano

- Programmi educativi per aumentare l'alfabetizzazione digitale e la comprensione dell'IA tra i cittadini

Conclusione

L'Italia si trova in una posizione unica per guidare l'innovazione responsabile nell'IA, bilanciando il progresso tecnologico con solidi principi etici. Attraverso una collaborazione continua tra governo, industria e accademia, il paese può creare un ecosistema di IA che non solo promuove l'innovazione ma protegge anche i diritti e i valori fondamentali dei suoi cittadini.

Mentre ci muoviamo verso un futuro sempre più guidato dall'IA, è essenziale mantenere un dialogo aperto e continuo su queste questioni etiche, assicurando che l'implementazione dell'IA in Italia rimanga allineata con i valori di equità, trasparenza e rispetto per i diritti umani.